Die menschliche Sprache als Vorbild

Seit drei Jahren ist David Schlangen Professor für Grundlagen der Computerlinguistik an der Universität Potsdam. Doch betritt er hier kein Neuland, schließlich forschte er als Postdoc zu Beginn des Jahrtausends schon viele Jahre in Potsdam und leitete hier ab 2006 die Emmy Noether-Gruppe „Incrementality and projection in dialogue processing“. Seit 2010 war er in Bielefeld Professor für Angewandte Computerlinguistik und dort am Exzellenzcluster „Cognitive Interaction Technology“ beteiligt. „Wiedergekommen bin ich wegen des sehr guten Instituts, der qualifizierten Kolleginnen und Kollegen und der Möglichkeiten, die mir die Stelle bietet“, erzählt der Wissenschaftler. „Außerdem ist der Master-Studiengang Cognitive Systems sehr schön und bringt gleichbleibenden Strom sehr guter Studierender nach Potsdam.“

Schlangen hat neben seiner heutigen Domäne übrigens auch Informatik und Philosophie studiert. Zur Computerlinguistik kam er über einen kleinen Umweg. „In Bonn habe ich zuerst zwei oder drei Semester Physik studiert, schon mit philosophischem Interesse. Zumindest im Grundstudium habe ich das aber nicht befriedigt gesehen.“ Ein Schulfreund hatte ihm dann vom Fach Computerlinguistik erzählt, das er damals nicht kannte. „Es war ja in den 1990er Jahren, als ich studiert habe, noch ein bisschen exotisch.“ So begann er gemeinsam mit dem Freund in Bonn das Studium. Die Brücke zur Philosophie kann Schlangen heute immer noch schlagen, denn sowohl die Sprachphilosophie als auch die Computerlinguistik befassen sich mit der Erzeugung von Bedeutung in der Interaktion. Vor 20 Jahren habe allerdings kaum jemand in der Computerlinguistik zu Dialogsystemen geforscht, erzählt der Wissenschaftler. Heute ist das sogenannte Natural Language Processing – und darin die Dialog- Forschung – als ein zentraler Bereich der Künstlichen Intelligenz etabliert. Doch nicht alle Forschenden haben einen linguistischen Hintergrund. „Viele im Fach meinen, dass sie als Informatikerin oder als Informatiker gar nicht so viel über die Domäne, in der die Maschine lernen soll, wissen müssen“, sagt Schlangen. „Das sehe ich naturgemäß anders. Aus meiner Sicht ist es wichtig, möglichst nah an der Sprachverarbeitung zu sein, wie sie bei Menschen abläuft.“

In der Emmy Noether-Gruppe arbeitete Schlangen mit seinem Team an Dialogsystemen, die Äußerungen schon verarbeiten, noch bevor sie vollständig sind. „Sprachsysteme hören in der Regel zu, bis man still ist, und beginnen erst dann mit der Verarbeitung des Gesagten.“ Dieses Verhalten empfinden wir Menschen oft als „unnatürlich“ oder störend. „Schließlich verstehen wir eine Aussage zumindest schon teilweise, noch während unser Gegenüber spricht, und können darauf reagieren“, sagt der Wissenschaftler. Deswegen geben wir ständig sogenannte Feedback- Signale: Wir nicken oder sagen „mhm“, um zu zeigen, dass wir folgen. „Ein Hörer beeinflusst durch sein kontinuierliches Feedback den Sprecher und ein guter Sprecher geht beständig auf die Signale des Hörers ein.“ Diese mitunter subtilen Zeichen sind es, die Schlangen an der Konversationsforschung interessieren.

Wenn Computer uns sagen, was wir zu tun haben

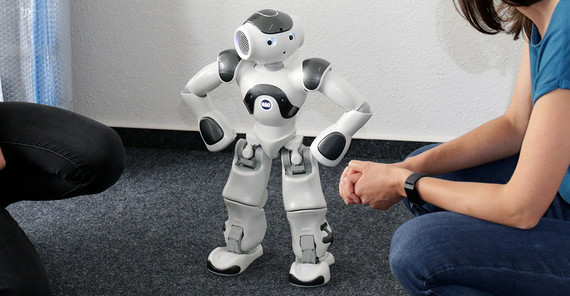

Der Fokus von Schlangen und seinem Team liegt auf der Sprache, doch die Forschenden beziehen auch den Körper und die physische Umgebung des Menschen ein. „Unser Ziel ist es, dass künstliche Systeme so in der Zeit situiert sind, wie das auch menschliche Gesprächspartner wären“, so Schlangen. „Wir wollen dahin kommen, dass eine Interaktion mit den Agenten mehr einem Gespräch von Angesicht zu Angesicht ähnelt als einer Chatunterhaltung.“ Daher verwenden die Potsdamer Computerlinguistinnen und -linguisten gerne Roboter, die einen Körper oder zumindest einen Kopf haben – wie etwa Furhat, der im Computerlinguistik-Labor an der Uni Potsdam für Studienzwecke zur Verfügung steht. Im RECOLAGEProjekt gibt Furhat dem Menschen Anweisungen – und zwar bei Pentomino. Das Spiel, das an den Klassiker Tetris erinnert, nutzt Schlangen seit seiner Postdoc-Zeit. „Es eignet sich als vereinfachte Domäne, die gewisse Freiheitsgrade, aber gleichzeitig eine relativ große Kontrolle bietet.“ Während die Anweisung gegeben wird, kann der Roboter an den Reaktionen des Menschen sehen, ob er richtig verstanden wurde. So könnte es zum Beispiel irgendwann möglich sein, dass ein Computersystem uns dabei hilft, ein Möbelstück nach einer Ikea-Anleitung zusammenzubauen – auch dank eines weiteren Bereichs der Künstlichen Intelligenz, der Bildverarbeitung.

„Nimm das Brett da hinten und die kleinen silbernen Schrauben“, könnte solch ein Computersystem etwa zu uns sagen. Über ein Tablet würde das System nicht nur erfassen, was wir sagen, sondern uns auch per Kamera zuschauen und uns helfen, die verschiedenen Bauteile um uns herum zusammenzusetzen. Greifen wir nach dem falschen Teil, soll es uns sofort korrigieren. „Nein, nicht das braune, sondern das grüne daneben.“ „Die sprachliche Korrektur ergibt sich aus dem jeweiligen Kontext, was die Sache so kompliziert macht“, sagt Schlangen. „Denn hier kommt es auf Millisekunden an.“ Wenn das Computersystem zum Beispiel beobachtet, dass die Hand des Menschen sich in die falsche Richtung bewegt, soll es noch währenddessen reagieren – in Echtzeit eben und nicht erst, wenn die Schraube im falschen Brett gelandet ist. Deswegen müsse der Computer vorhersehen, wohin der Mensch greifen wird. Das könne auch schiefgehen, wenn der Roboter eine Bewegung vorhersagt, die wir gar nicht beabsichtigt hatten. „So etwas kann aber genauso bei zwei Menschen, die sich gut kennen, zu Unfrieden führen“, sagt Schlangen und lacht. Damit die Anweisungen des Systems einfach zu interpretieren und umzusetzen sind, muss die gemeinsame Basis des Verstehens zwischen Maschine und Mensch ausgehandelt werden. Welche technischen Begriffe soll der Computer erklären, welche kann er voraussetzen? Denn wenn das menschliche Gegenüber die Anweisungen nicht versteht oder sich nicht richtig verstanden fühlt, empfindet es die Kommunikation als anstrengend – und das System wäre keine echte Unterstützung mehr.

Auch wenn die Frage nach der Anwendung nicht Teil des Forschungsprojekts ist, sind die Ergebnisse von RECOLAGE für persönliche Assistenten in jeder Hinsicht denkbar. Vorstellbar wäre auch, dass uns ein künstlicher Agent beim Kochen durch ein Rezept führt. „Der Konzern Amazon arbeitet gerade an der Entwicklung eines solchen Systems“, erzählt der Wissenschaftler. Informatikerinnen und Informatiker in der Wirtschaft befassen sich oft mit ganz ähnlichen Problemen wie Schlangen und sein Team. „In meinem Feld ist extrem viel Geld unterwegs. Große Firmen unterhalten Forschungsbereiche und veröffentlichen auch.“ In Potsdam wird jedoch Grundlagenforschung betrieben, hier geht es nicht um Produktentwicklung. „Insofern herrscht zwischen uns und der Wirtschaft eine weitgehend freundschaftliche Konkurrenz.“

Mit Computermodellen menschliches Verhalten simulieren

Das maschinelle Lernen ist ein wesentliches Element in Schlangens Forschung. Dabei geht es darum, Wissen aus Erfahrung zu erzeugen: Das Computersystem erhält Lerndaten, leitet daraus Regeln ab und kann diese im besten Fall auf neue Situationen anwenden. Der Computerlinguist steht den Deep-Learning-Modellen – einer bestimmten Methode des maschinellen Lernens, bei der künstliche neuronale Netze ein tiefergehendes Lernen erlauben sollen – aber zum Teil kritisch gegenüber. „Ich komme von einer etwas traditionelleren Herangehensweise, in der es üblich ist, theoretisch zu starten. Wir möchten Theorien entwickeln, die etwas erklären und nicht nur ‚machen‘, wie es bei Deep-Learning-Modellen der Fall ist.“ Zwar könnten solche Modelle sehr überzeugend aussehen, wenn es zum Beispiel um eine kurze Chat-Unterhaltung geht. „Wenn wir es aber mit einem verkörperten Computersystem zu tun haben, mit einem Roboter in menschlicher Gestalt, muss sehr viel gleichzeitig gesteuert werden – nicht nur die Sprache, auch Mimik und Gestik, und das alles in kurzer Zeit.“ Der Roboter kann schließlich nicht einen Gesichtsausdruck zehn Sekunden beibehalten, bis der nächste kommt – denn das würde vom Menschen schon wieder interpretiert werden. Weil Deep-Learning-Modelle nicht von Situationen in Echtzeit gelernt haben, sondern mit „toten“ Daten, sind sie aus Sicht des Wissenschaftlers nur begrenzt geeignet, unter Zeitdruck Informationen zu verarbeiten und entsprechend zu reagieren. „Damit das Verhalten der künstlichen Agenten in die Situation passt, brauchen wir also weitere Computermodelle, die extrem dynamisch sein müssen.“

Deswegen arbeitet der Forscher mit Kognitionswissenschaftlerinnen und -wissenschaftlern der Uni Potsdam zusammen, die kognitive Prozesse modellieren. „Wir konsumieren unterschiedliche Modelle unserer Kolleginnen und Kollegen, die sehr präzise an kleineren Phänomenen arbeiten, wie zum Beispiel der Vorhersage von Blickbewegungen. Unsere Aufgabe ist es, diese Theorien zusammenzusetzen und auf diese Weise Sprachsysteme zu entwickeln, die menschliches Verhalten simulieren.“ Außerdem planen die Forschenden, künftig Roboter für psychologische oder linguistische Experimente einzusetzen – ein bisher eher ungewöhnliches Vorgehen, für das es jedoch gute Argumente gibt. „Sie eignen sich sehr gut als kontrolliertes Gegenüber. Ein Roboter kann gnadenlos Stimuli produzieren, die für jeden Probanden exakt identisch sind.“

Wenn uns die Computersysteme scheinbar immer ähnlicher werden, kommt die Frage auf, worin sie sich überhaupt noch von uns unterscheiden. In seiner Forschung ist David Schlangen häufig mit dem Phänomen konfrontiert, dass gerade das, was uns Menschen leichtfällt, für Computer schwierig ist (und umgekehrt – man denke nur an anspruchsvolle Rechenaufgaben). So sei zum Beispiel der Small Talk für Menschen eine unkomplizierte Alltagsübung, Computersysteme aber stellt er vor Herausforderungen – sie machen dabei regelmäßig Fehler. „Das ist gar nicht so schlimm, das passiert uns ja auch. Wir sind aber anders als Computer sehr gut darin, uns zu korrigieren.“ Für den Wissenschaftler ist daher klar, dass die Computersysteme uns Menschen nicht perfekt simulieren können – im Gegenteil, es sollte stets klar sein, dass es sich um künstliche Agenten handelt. „Doch sie sollten verstehbar sein und situativ angemessen reagieren, sich ‚natürlich‘ verhalten.“ Warum aber ist es offenbar so schwierig, bei künstlichen Agenten „natürliches“ Verhalten zu erreichen? „Vielleicht fehlt ihnen etwas Grundlegendes“, vermutet Schlangen. „Sie werden mit Text gefüttert, während das Neugeborene vom ersten Moment an in Interaktionen gefördert und gefordert wird. Interaktion ist für uns Menschen fundamental und gehört zu den angeborenen Lernmechanismen. Wir lernen nicht in passiven Beobachtungssituationen, sondern wollen uns verstehen und uns mitteilen. Wesentlich für unsere menschliche Interaktion ist aus meiner Sicht, dass wir einander selbst und unser Gegenüber als intentionale Agenten begreifen.“ Dass Computersysteme mithilfe der aktuellen Methoden bald schon natürlich, vielleicht sogar absichtsvoll kommunizieren können, glaubt Schlangen daher eher nicht. „Andererseits hätte ich das, was Künstliche Intelligenz heute kann, vor zehn Jahren auch noch nicht für möglich gehalten.“

Das Projekt

RECOLAGE: Kollaborative Sprachgenerierung in Echtzeit und aus visuellem Input

Förderung: Deutsche Forschungsgemeinschaft (DFG)

Laufzeit: 12/2019–11/2023

Leitung: Prof. Dr. David Schlangen

Der Forscher

Prof. Dr. David Schlangen studierte Computerlinguistik, Informatik und Philosophie. Er ist seit 2019 Professor für die Grundlagen der Computerlinguistik an der Uni Potsdam.

E-Mail: david.schlangenuuni-potsdampde

Dieser Text erschien im Universitätsmagazin Portal Wissen - Eins 2023 „Lernen“ (PDF).