„Can you rotate that piece? Rotate it again. Down. Down!“

„Sorry, my speech recognizer is not working.“

„Stop! Move it two rows up.“

„Sorry?“

„We need to rotate it to the left, now move it to the right.

„Pardon?“

„Stop, move it down.“

„We are making progress! Shall I move it to the right?“

„That would be excellent.“

„A simple yes or no is enough.“

(Lacht.) „We need to mirror it; stop, stop, stooop!“

„Good work, I see you understood the game.“

„Mit Maske versteht er einen schlecht“, entschuldigt Maike Paetzel-Prüsmann ihren Gesprächspartner Furhat, mit dem sie gerade Pentomino gespielt hat. Furhat ist ein Roboter in Form eines menschenähnlichen Kopfs. In dem Computerspiel, das an den Klassiker Tetris erinnert, hat die Informatikerin dem Roboter Anweisungen gegeben, wohin er eine geometrische Form legen soll. Mehr als einmal fallen sich die beiden ins Wort, doch Furhat hat Humor und das Talent, soziale Spannungen in Wohlgefallen aufzulösen. „Die Studierenden haben seine witzigen Antworten programmiert“, sagt die Informatikerin. Und die können auch für die Wissenschaftlerin hin und wieder überraschend sein.

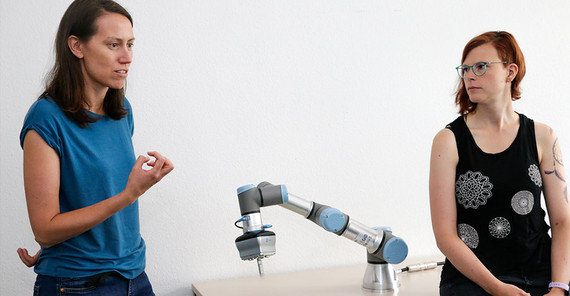

Im Computerlinguistik-Labor in Golm arbeiten Dr. Maike Paetzel-Prüsmann und Dr. Jana Götze an Mensch-Maschine-Interaktionen. Die beiden kleinen Räume des Labors sind recht unscheinbar: ein paar graue Tische und Schränke, dunkler Teppichboden und weiße Wände. Auf einem Tisch thront Furhat, eine Büste mit projiziertem menschlichen Gesicht, auf einem anderen ein Roboterarm wie aus einer Fabrikhalle. An einer Wand lehnt der circa einen halben Meter große Nao. Und dann wäre da noch Alexa, die Sprachassistentin der besonderen Art.

Sprache ist ihr Fokus

Das Labor gehört zu den beiden Professuren Grundlagen der Computerlinguistik und Angewandte Computerlinguistik von Prof. Dr. David Schlangen und Prof. Dr. Manfred Stede. Es steht den Studierenden aus dem Bachelor Computerlinguistik und dem Master Cognitive Systems sowie Promovierenden offen: Sie führen hier Studien für ihre Abschlussarbeiten oder Dissertationen durch und programmieren die Roboter.

„Die Sprache ist unser Fokus“, sagt Jana Götze. Die Wissenschaftlerinnen, die beide bei Prof. Schlangen arbeiten, erforschen einerseits das Sprachverstehen: Im Falle eines Roboters geht es ihnen nicht um die Frage, ob er Wörter und Sätze richtig erkennen kann, sondern ob er weiß, was damit gemeint ist. Andererseits untersuchen sie die Sprachgenerierung, wollen die Roboter also in die Lage versetzen, sinnvoll auf Aussagen ihres Gegenübers einzugehen. In Studien analysieren die Computerlinguistinnen sowohl Dialoge zwischen Menschen als auch zwischen Robotern und Menschen – sie wollen herausfinden, wie sich die Mensch-Mensch- von der Mensch-Maschine-Interaktion unterscheidet. Zum Beispiel beim Pentomino-Spielen: Die Forscherinnen filmen Versuchsteilnehmende dabei, wie sie ihrem Gegenüber – entweder anderen Menschen oder eben Furhat – erklären, wo es ein Teil hinlegen soll. „Eine sehr vereinfachte und immer noch genügend komplizierte Domäne“, so die Computerlinguistin. „Wir machen viel Grundlagenforschung“, ergänzt Paetzel-Prüsmann. „Diese natürlichen Interaktionen beim Spielen lassen sich später in ganz vielen Bereichen anwenden.“ Zum Beispiel für Roboter, die zuhause als persönliche Assistenten, in der Schule als Lernhelfer, im Museum als Führer oder in der Industrie „arbeiten“.

Seit Beginn der Corona-Pandemie haben die Forscherinnen Studien mit Furhat virtuell durchgeführt. „Vorher kamen die Leute zu uns ins Labor“, erzählt Paetzel-Prüsmann. Allerdings verhalten sich die Probandinnen und Probanden unter Laborbedingungen oft anders, wenn sie nämlich ein Mikrofon, mehrere Kameras und einen Eye Tracker in Form einer Brille vorm Gesicht haben. Diese zeichnen neben den Dialogen auch Körperhaltung, Mimik oder Gestik auf. „Je mehr Daten wir sammeln wollen, desto mehr Equipment brauchen wir“, sagt die Informatikerin. Einen großen Unterschied mache es auch, ob die Menschen selbst schon Sprachassistentinnen wie Alexa nutzen. Denn Alexa reagiert am besten auf einen Kommandostil. „Die Menschen haben sich daran gewöhnt – wir wollen aber Roboter auf Mensch-Mensch-Kommunikation trainieren und nicht auf Mensch-Roboter-Kommunikation.“ Passen sich die Menschen auch daran an, wie Furhat spricht? Das konnten die Forscherinnen schon beobachten. „Wenn Furhat zur Beschreibung eine geometrische Form nutzt, begannen auch die menschlichen Gesprächspartner beim Spielen von Kreisen, Quadraten oder Dreiecken zu sprechen.“

Das Problem mit dem Sexismus

Die Computerlinguistinnen untersuchen aber nicht nur Dialoge, sondern auch Gestik, Mimik und Körperhaltung. Furhat kann gewissermaßen vom weiblichen ins männliche Geschlecht und zurück wechseln, seine Züge und Stimme verändern sich dann. Manchmal zeigt er ein feines Lächeln, im nächsten Moment strahlt er übers ganze Gesicht. Er kann Überraschung ausdrücken oder vertraulich zwinkern. „Die Mimik muss passen, sonst sorgt das für Irritationen bei den Menschen“, sagt Maike Paetzel-Prüsmann. Fest steht: Menschen spiegeln Emotionen, auch bei Robotern – wenn auch nicht so intensiv wie bei Menschen. Mit einer Studentin hat die Wissenschaftlerin auch untersucht, welche Rolle Furhats Gesichtsausdruck spielt. „Mimik verstärkt das Gesagte. Passt der Gesichtsausdruck nicht zu einer positiven Aussage, wird sie zwar noch als freudig wahrgenommen, aber weniger intensiv.“

„Gestik und Mimik sind aber nicht nur Emotion“, erklärt Jana Götze. „Mit deinem Nicken und deinem Blick kannst du auch signalisieren, dass du mich verstehst.“ Eine Bachelor-Studentin untersucht derzeit, ob Menschen über die Gestik des Roboters erkennen können, ob er sie versteht oder nicht. So könnte man sich verbale Nachfragen sparen. „Auch wenn wir Menschen uns etwas erklären, verstehen wir uns nicht immer sofort. Wir müssen manchmal nachfragen oder uns korrigieren“, so Götze. Genauso ist es bei den Mensch-Roboter-Gesprächen.

Die großen Internetkonzerne wie Amazon oder Google können auf unendlich viele Daten zugreifen, um ihren Sprachassistenten das Sprechen beizubringen. So kann Google ganz YouTube auswerten, das zum Konzern gehört. Doch das hat auch eine Kehrseite. „Große Sprachmodelle, die Millionen von Daten einspeisen, haben oft Probleme mit Rassismus oder Sexismus“, sagt Jana Götze. „Wir verwenden sie nicht.“ Stattdessen „crowdsourcen“ die Wissenschaftlerinnen: „Wir akquirieren Leute online und lassen die Roboter von ihren Dialogen lernen“, erklärt Paetzel-Prüsmann. „So nutzen wir eher 5.000 Datensätze. Aber auch hier passiert es oft, dass Sexismus reproduziert wird.“ Zum Beispiel, wenn im Small Talk Sätze fallen wie: „Have you seen what our hot secretary is wearing this morning?“ „Leute im Internet finden das offenbar weniger sexistisch als wir“, so die Informatikerin. Die Forscherinnen gehen deswegen alles noch einmal manuell durch, damit Furhat keine rassistischen oder sexistischen Aussagen wiederholt.

Wenn Roboter halluzinieren

„Das ist unsere neuste Anschaffung“, so Paetzel-Prüsmann und deutet auf eine Apparatur auf einem Tisch. „Ein industrieller Roboterarm.“ Die leeren Pappkartons in der Ecke mit der Aufschrift „Universal Robots“ zeugen noch von der Anlieferung. Roboter zu kaufen, ist übrigens ein teures, aber auch langwieriges Unterfangen. 20.000 Euro hat der Roboterarm gekostet, dafür mussten Anträge geschrieben und eine Ausschreibung veröffentlicht werden. „Es dauert lange, bis so ein Roboterarm da und installiert ist“, sagt die Wissenschaftlerin. Der Schrank, auf dem er stehen soll, ist erst vor zwei Tagen gekommen. Er hing im Zoll fest.“

In einem deutsch-französischen Projekt, an dem auch Partner aus der Industrie beteiligt sind, möchten die Forscherinnen die Programmierung von Robotern vereinfachen. „Die Fabrikbeschäftigten sind dafür in der Regel nicht ausgebildet und Fachleute zu beauftragen, ist teuer.“ Ziel des Projekts ist es, den Roboter dialogfähig zu machen, damit die Arbeitenden in der Fabrik ihm erklären können, was sie von ihm wollen: zum Beispiel, dass er vier Löcher auf einem Board mit vier Brücken verbinden und anschließend in jedes Loch eine Schraube stecken soll. Doch was, wenn die Brücken oder Schrauben verschiedene Farben haben? Da kann es schon kompliziert werden. Im Idealfall würde der Roboter fragen: „Du hast gesagt, da sollen blaue Schrauben rein. Ich sehe aber nur rote, soll ich die nehmen?“

„Bis unsere Dialogsysteme in der Industrie implementiert werden können, müssen noch zahlreiche Probleme gelöst werden“, so Paetzel-Prüsmann. Denn die Bedingungen in der realen Welt können anders sein als die im Labor, wo die Roboter sprechen lernen. „Das Situative ist das Herausfordernde“, sagt die Forscherin. So kann es „unglaublich laut“ sein in einer Fabrikhalle. Da sich die Wissenschaftlerinnen nicht mit der Spracherkennung, sondern dem Sprachverstehen beschäftigen, können sie ein solches Problem aber gar nicht lösen. Wieviel sollte der Roboter selbstständig annehmen und wie oft soll er nachfragen? In jedem Fall eine wichtige Frage. Schließlich kann ein Roboter, der ständig Fragen stellt, ziemlich nervtötend sein. Gleichzeitig können Sprachmodelle, die auf Millionen von Datensätzen trainiert sind, etwas erfinden, was es nicht gibt – zum Beispiel eine Mutter zur Schraube, weil diese im Datenfutter häufig dazugehörte. „Dass Roboter Dinge ‚halluzinieren‘, kann man sich im industriellen Kontext nicht leisten. Sie sollen nicht ‚kreativ‘ sein und eigenständig Dinge machen.“

Plötzlich erklingt eine weibliche Stimme im Labor. „Herzlich willkommen zum großen Wimmelbild-Spaß!“ „Alexa hat sich heute nicht eingemischt, normalerweise ist sie sehr gesprächig“, sagt Paetzel-Prüsmann. Doch Alexa ist jetzt bereit für ein Spiel und erklärt ausführlich die Regeln. Im Computerlinguistik-Labor kann man sein eigenes Wort nicht mehr verstehen. „Alexa, stopp!“, ruft die Wissenschaftlerin. „Ok, dann tschüss“, erwidert die Assistentin. Studierende haben für sie ein Wimmelbild-Spiel entwickelt, bei dem sich Mensch und Alexa wechselseitig einen Gegenstand auf einem übervollen Bild beschreiben. „Alexa eignet sich gut für Studierende, die zum ersten Mal mit Sprachdialogsystemen arbeiten“, erklärt Jana Götze.

Maschinen mit Persönlichkeit?

Und was ist eigentlich mit dem kindlich anmutenden kleinen Roboter Nao, der an einer Wand lehnt? „Wir benutzen ihn zurzeit selten“, so Götze. Aber nicht aus Antipathie, wie schnell klar wird. Nao sagt nach dem Start erstmal seine IP-Adresse auf, dann sucht er nach Gesichtern, blinzelt, macht Atembewegungen. Er stemmt einen Arm in die Seite, hört zu und nickt. „Wir nennen das ‚Lebensverhalten‘“, so die Computerlinguistin. „All diese Bewegungen sollen Lebendigkeit ausdrücken.“ Nao kann aber auch laufen, sitzen, zeigen und sogar tanzen. Professor Martin Fischer vom Department Psychologie, der sich mit der Beziehung zwischen Mensch und Roboter beschäftigt, macht öfter Studien mit der niedlichen Maschine. „Nao ist mein Lieblingsroboter“, sagt Götze und lacht. „Er ist wie ein Spielzeug.“ Auch Maike Paetzel-Prüsmann sieht Unterschiede zu ihrem Masterstudium, als sie nur mit Computersystemen gearbeitet hat. „Man baut eine Verbindung zum Roboter auf. Abends muss Furhat in den Schrank ziehen, und dann habe ich das Bedürfnis, ihm eine gute Nacht zu wünschen.“

Dieser besondere Forschungsgegenstand fesselt die beiden Wissenschaftlerinnen. Jana Götze hat Computerlinguistik in Potsdam auf Diplom studiert. „Damals waren Mensch-Roboter-Interaktionen noch nicht so ein Ding. Aber dann bin ich auf Sprachdialogsysteme gestoßen und die haben mich fasziniert.“ Die Erforschung von Interaktionen findet sie spannender als die Textverarbeitung, ein weiterer Bereich der Computerlinguistik. „Mich interessiert die spontane Produktion von Sprache.“ Maike Paetzel-Prüsmann hat Informatik studiert und sich im Master auf Robotik spezialisiert. „Im Studium habe ich unter anderem mit Robotern Fußball gespielt“, sagt sie und lacht. Promoviert hat sie zu Mensch-Roboter-Interaktionen. „Es ist ein großer Unterschied, ob etwas vor einem sitzt, das sich bewegt und etwas macht. Das fasziniert mich und daher bin ich in der verkörperten Computerlinguistik gelandet.“

Was die Ziele der beiden Forscherinnen sind? „Die Intention jedes Projekts ist es, dass der Roboter erfolgreiche Interaktionen ausführen kann“, sagt Jana Götze. „Dass Dialoge entstehen, die als natürlich empfunden werden.“ Maike Paetzel-Prüsmann interessiert besonders auch die Persönlichkeit von Robotern: „Meine Vision ist, dass wir es schaffen, dass sie angenehme, vielleicht auch überraschende Gesprächspartner sind. Dass der Roboter im positiven Sinne eine eigene Persönlichkeit zeigt.“

Dieser Text erschien im Universitätsmagazin Portal - Zwei 2022 „Artensterben“ (PDF).